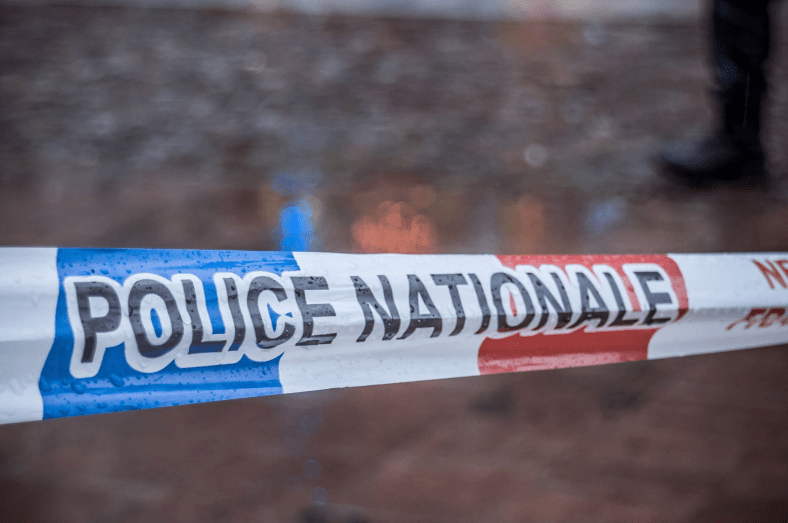

Les plateformes cryptées pourraient devenir des dommages collatéraux dans une initiative législative qui traite la vie privée elle-même comme un handicap.

Sous prétexte de renforcer les mesures contre l’exploitation des enfants en ligne, un projet de loi controversé du Sénat refait surface avec des dispositions qui, selon les défenseurs de la vie privée, videraient de leur substance les protections essentielles d’Internet et compromettraient la sécurité et la vie privée de tous les citoyens.

Connue sous le nom de loi STOP CSAM de 2025 (S. 1829), la législation est critiquée pour son utilisation d’un langage large et de normes juridiques vagues qui pourraient gravement affaiblir le cryptage et ouvrir la voie à des suppressions de contenu, y compris de contenu légal, sur un large éventail de services en ligne.

Nous avons obtenu une copie de la facture pour vous ici .

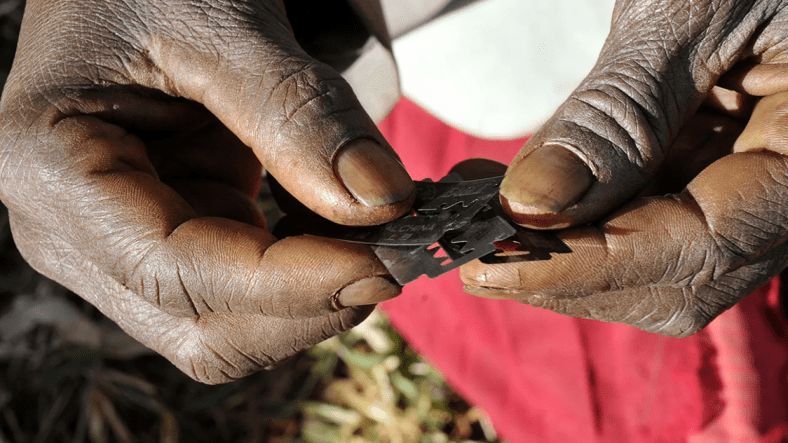

L’objectif affiché du projet de loi est de freiner la diffusion de contenus pédopornographiques, un crime déjà strictement interdit par la loi fédérale. La réglementation actuelle oblige déjà les plateformes en ligne à signaler les cas avérés de tels contenus au Centre national pour les enfants disparus et exploités, qui coordonne ses actions avec les forces de l’ordre.

Toutefois, le projet de loi S. 1829 va bien au-delà de ce mandat existant, en ciblant un large éventail de plateformes Internet avec de nouvelles formes de responsabilité pénale et civile qui pourraient pénaliser même les services les plus soucieux de la vie privée et les plus conformes.

La portée de la législation est vaste. Ses dispositions s’appliquent non seulement aux grandes plateformes de médias sociaux, mais aussi aux applications de messagerie privée, aux services de stockage en nuage et aux fournisseurs de messagerie électronique.

En introduisant de nouveaux délits liés à l’« hébergement » ou à la « facilitation » de contenus abusifs, et en utilisant des termes juridiques aux contours flous, le projet de loi expose les plateformes chiffrées à un risque important. Selon la définition vague du projet de loi, la simple fourniture d’un service sécurisé et respectueux de la vie privée pourrait être interprétée comme une « facilitation » d’activités illégales, que le fournisseur puisse ou non accéder au contenu transmis ou le vérifier.

Cela est particulièrement dangereux pour les services qui mettent en œuvre le chiffrement de bout en bout, une fonctionnalité essentielle conçue pour protéger les communications des utilisateurs contre les pirates informatiques et la surveillance non autorisée.

Étant donné que ces plateformes ne peuvent accéder au contenu des utilisateurs, elles pourraient être tenues responsables de contenus qu’elles ne voient ni ne contrôlent. Un simple avis alléguant la présence d’abus sexuels sur des enfants pourrait suffire à atteindre le seuil de connaissance fixé par le projet de loi, exposant ainsi les fournisseurs à des poursuites judiciaires sans preuve concrète.

Bien que la législation offre ce qui semble être une garantie, une défense juridique pour les services qui peuvent prouver qu’il est « technologiquement impossible » de supprimer le CSAM sans compromettre le cryptage, elle offre peu de protection significative.

Cette défense contraint encore les entreprises à intenter des poursuites judiciaires, les obligeant à engager des ressources pour démontrer leur innocence devant les tribunaux. Les petites startups et les plateformes alternatives seraient particulièrement vulnérables, ce qui pourrait dissuader de nouveaux entrants sur le marché et consolider le contrôle entre les mains d’une poignée de géants de la technologie.

Des membres du Congrès ont publiquement suggéré que des techniques comme l’analyse côté client pourraient résoudre le problème du chiffrement et de la détection. Cette affirmation a été maintes fois démentie par les experts en sécurité, qui avertissent que de tels outils compromettent l’essence même de la communication sécurisée.

Si la loi STOP CSAM est adoptée, de nombreuses plateformes pourraient adopter une analyse invasive par peur, et non par nécessité, simplement pour éviter toute responsabilité, avec de réelles conséquences sur la confidentialité et la confiance des utilisateurs.

Tout aussi alarmante est la tentative du projet de loi de réécrire l’article 230, une loi fondamentale qui protège les plateformes contre les poursuites judiciaires liées aux contenus générés par les utilisateurs. En créant une nouvelle exemption pour les actions civiles liées à la facilitation présumée de contenus pédopornographiques, le projet de loi ouvre la voie à des poursuites contre des intermédiaires en ligne pour des propos qu’ils n’ont pas créés et qu’ils ne peuvent pas toujours contrôler.

En l’absence des protections de l’article 230 , de nombreuses plateformes peuvent recourir à une modération agressive, supprimant l’expression légale pour éviter d’éventuels problèmes juridiques.

Les conséquences ne se limiteraient pas aux acteurs malveillants. Les utilisateurs ordinaires pourraient voir leurs publications supprimées, leurs comptes suspendus ou leur accès à des outils de communication bloqué ; non pas parce que leur contenu est illégal, mais parce que les plateformes craignent d’être tenues responsables. Pour de nombreuses communautés, notamment celles qui dépendent de services chiffrés pour leur sécurité, cette législation menace non seulement leur vie privée, mais aussi leur capacité à s’exprimer et à s’organiser en ligne.

Voir l’article original cliquez ci-dessous :