Donald Trump a été qualifié de « clown » pour avoir publié une photo de lui en tant que pape.

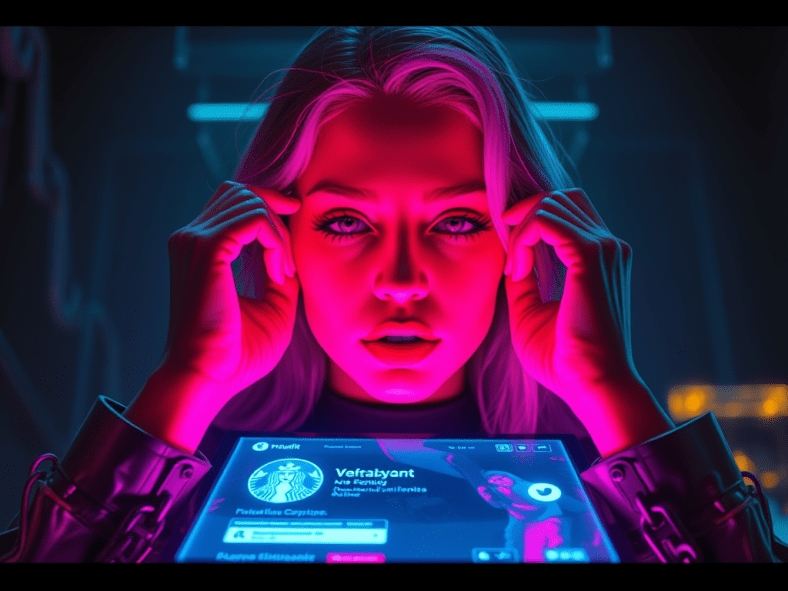

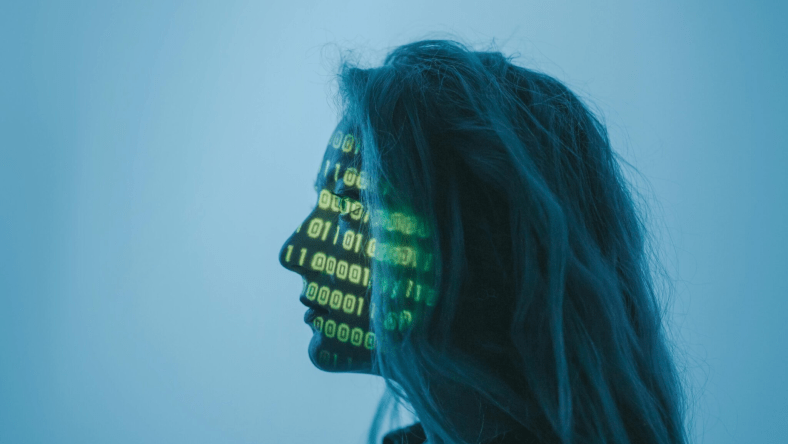

L’image générée par l’IA a provoqué la colère avant le rassemblement des cardinaux cette semaine au Vatican pour choisir un nouveau chef de l’Église catholique, forte de 1,4 milliard de membres.

Cela survient quelques jours seulement après que le président américain a plaisanté en disant qu’il « aimerait être pape ».

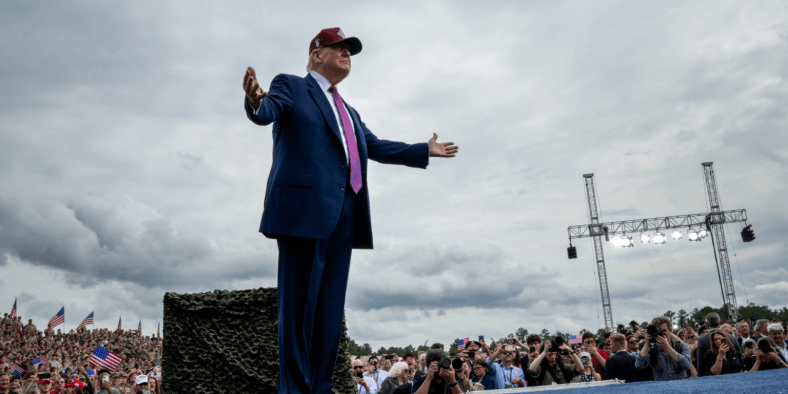

Trump, qui n’est pas catholique et ne fréquente pas régulièrement l’église, a publié l’image sur sa plateforme Truth Social vendredi soir, moins d’une semaine après avoir assisté aux funérailles du pape François , décédé à l’âge de 88 ans le lundi de Pâques.

La Maison Blanche l’a ensuite republié sur son compte officiel X.

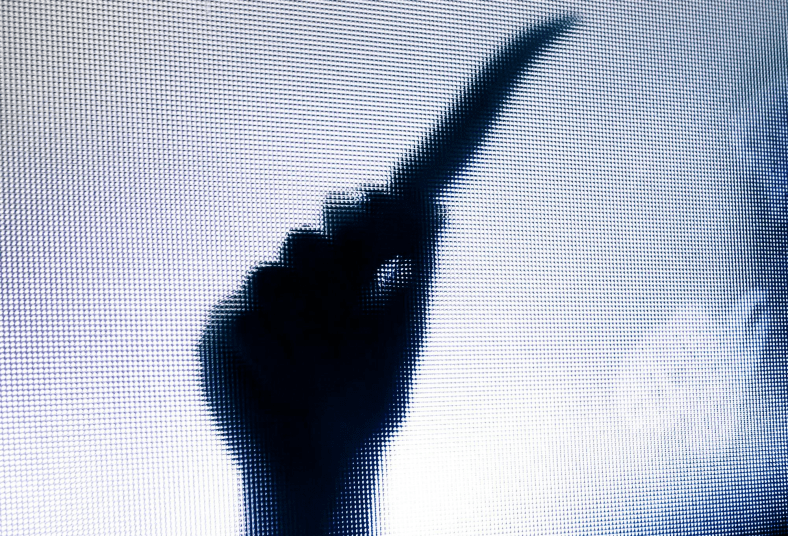

L’image montre un Trump sans sourire assis sur une chaise ornée, vêtu de vêtements et d’une coiffe papale blancs, l’index droit levé vers le ciel.

Ce message irrévérencieux a immédiatement suscité l’indignation, notamment de la part des Républicains contre Trump, un groupe qui se décrit comme « des Républicains conservateurs pro-démocratie luttant contre Trump et le trumpisme ».

Le groupe a republié l’image sur X, la qualifiant d’« insulte flagrante aux catholiques et de moquerie de leur foi ».

Le porte-parole du Vatican, Matteo Bruni, a refusé de commenter l’image lors d’un point de presse avec des journalistes sur le processus d’élection d’un nouveau pape, qui commence le 7 mai.

L’ancien Premier ministre italien Matteo Renzi a écrit sur X : « C’est une image qui offense les croyants, insulte les institutions et montre que le leader de la droite mondiale aime être un clown.

« Pendant ce temps, l’économie américaine risque la récession et le dollar perd de la valeur. »

Plus près de chez nous, les évêques catholiques de l’État de New York ont également exprimé leur mécontentement.

« Il n’y a rien d’intelligent ou de drôle dans cette image, Monsieur le Président », ont-ils écrit sur X.

Nous venons d’enterrer notre cher pape François et les cardinaux s’apprêtent à entrer en conclave solennel pour élire un nouveau successeur de saint Pierre. Ne vous moquez pas de nous.

Trump avait déclaré mardi en plaisantant qu’il serait son propre premier choix pour devenir le prochain pape, avant d’ajouter qu’il y avait un « très bon » candidat à New York, le cardinal Timothy Dolan.

Dolan, l’ archevêque de New York, ne figure pas sur la liste des candidats potentiels, mais elle comprend un autre Américain, le cardinal Joseph Tobin, archevêque de Newark, dans le New Jersey.

Il n’y a jamais eu de pape originaire des États-Unis.

Réagissant au mème diffusé à West Palm Beach samedi matin, alors qu’elle attendait l’arrivée du cortège de Trump à son club de golf, Debbie Macchia, une habitante de 60 ans, a déclaré : « Il plaisantait clairement. Il plaisantait clairement. »

« Mais je ne voudrais pas les voir faire quoi que ce soit de sacrilège avec le pape, ou quoi que ce soit. »

À la mi-février, Trump et les comptes officiels de la Maison Blanche sur les réseaux sociaux ont publié une autre image du président générée par l’IA, qui a suscité des critiques car elle le représentait portant une couronne, largement interprétée comme impliquant qu’il croyait jouir des pouvoirs d’un roi.

« LA TARIFICATION ANTI-CONGESTION EST MORTE. Manhattan, et tout New York, sont SAUVÉS », pouvait-on lire en légende. « VIVE LE ROI ! »

Voir l’article original cliquez ci-dessous :