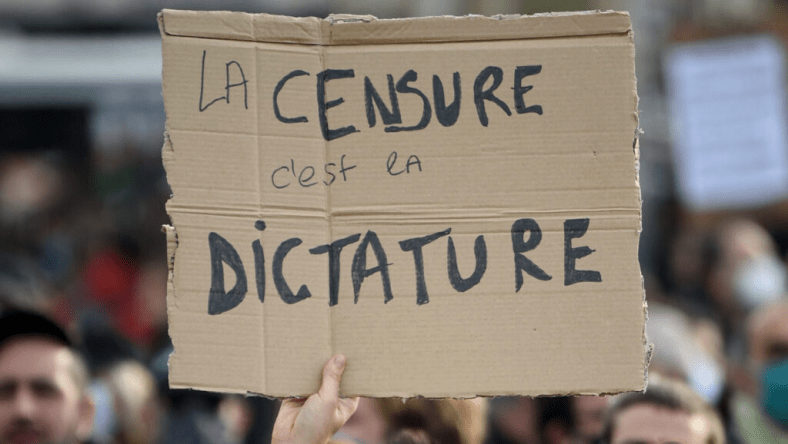

Le Congrès est en train de construire une machine de censure déguisée en protection de l’enfance et en droits des artistes.

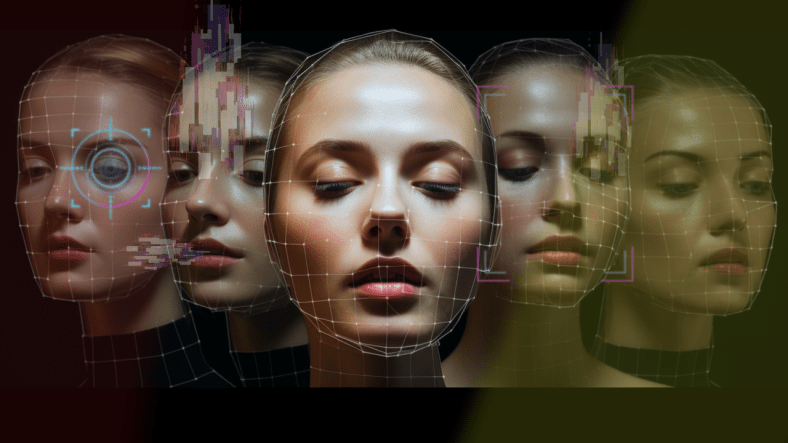

Lors d’une audience de la commission judiciaire du Sénat tenue le 21 mai 2025, intitulée « Le bon, la brute et le truand : les deepfakes générés par l’IA en 2025 », les législateurs et les intervenants invités se sont ralliés à deux mesures très controversées : la loi TAKE IT DOWN récemment promulguée et la loi NO FAKES en attente .

Ces deux propositions, sous le signe de la lutte contre l’utilisation abusive de l’IA, élargiraient considérablement le pouvoir des gouvernements et des entreprises de censurer unilatéralement le contenu numérique, ce qui poserait de graves risques pour la liberté d’expression.

La sénatrice Marsha Blackburn (R-TN) a salué les deux projets de loi, mettant en garde contre une « augmentation profondément inquiétante » du contenu explicite généré par l’IA.

« Nous devons agir », a-t-elle déclaré. « La loi No Fakes Act et la loi Take It Down Act, que le président Trump vient de promulguer cette semaine, contribuent grandement à mieux protéger nos enfants contre ces deepfakes. » Évoquant l’utilisation abusive d’images et de voix de célébrités dans des escroqueries, elle a déclaré : « Le Congrès doit agir », ajoutant qu’elle et ses collègues entendent « travailler sur la loi No Fakes Act et la soumettre au président Trump cette année. »

La sénatrice Amy Klobuchar (Démocrate-Minnesota) a également salué la nouvelle loi, la qualifiant de « premier pas », faisant référence à la loi TAKE IT DOWN qu’elle a coparrainée avec le sénateur Cruz. « Elle a eu des conséquences néfastes considérables, une vingtaine de suicides de jeunes enfants par an », a-t-elle déclaré, faisant référence à l’impact des images explicites non consensuelles. Klobuchar a souligné : « Nous avons également besoin de règles pour garantir que les technologies d’IA donnent du pouvoir aux artistes et aux créateurs, et non les affaiblissent. » Elle a rappelé que l’artiste nominé aux Grammy Awards, Cory Wong, l’avait avertie que « les répliques numériques non autorisées menacent les moyens de subsistance des artistes et compromettent leur capacité à créer de l’art. »

Christen Price, conseillère juridique principale au Centre national sur l’exploitation sexuelle, a affirmé que « la technologie deepfake permet à n’importe quel homme de transformer n’importe quelle femme en pornographie ».

Citant Andrea Dworkin, elle a déclaré : « On vit dans un cauchemar d’abus sexuels, réels ou potentiels, et on a la grande joie de savoir que son cauchemar est la liberté de quelqu’un d’autre, le plaisir de quelqu’un d’autre. » Price a soutenu la loi NO FAKES, ainsi que d’autres projets de loi, affirmant : « Ces projets de loi contribuent à protéger les individus des effets néfastes des abus sexuels basés sur des images et augmentent la pression sur les entreprises technologiques pour qu’elles gèrent les sites Web de manière plus responsable. »

Mitch Glazier, PDG de la Recording Industry Association of America, a qualifié la loi TAKE IT DOWN de « modèle incroyable », tout en insistant sur le fait qu’elle « a ses limites ». Il a mis en garde contre « une fenêtre de manœuvre très étroite et inhabituelle pour permettre au Congrès d’anticiper la situation avant que celle-ci ne devienne irréparable ». Plaidant pour une adoption rapide de la loi NO FAKES, Glazier a déclaré que les plateformes doivent agir avant que le contenu ne « devienne viral très, très rapidement », arguant que ces lois permettront le retrait de contenu « dès que techniquement et pratiquement possible ».

Justin Brookman, de Consumer Reports, a souligné l’utilisation abusive des outils d’IA vocale et vidéo dans les escroqueries et la désinformation. Il a expliqué que « des outils de clonage réalistes sont facilement accessibles au public, très bon marché et faciles à utiliser ».

Après avoir testé six plateformes de clonage vocal, il a constaté que « quatre des six entreprises étudiées n’avaient recours à aucun mécanisme technique, ni à aucun mécanisme technique raisonnable, pour garantir raisonnablement le consentement de la personne dont la voix était clonée. » Brookman a soutenu que « les développeurs de ces outils doivent être soumis à des obligations renforcées pour tenter de prévenir les utilisations nuisibles », ajoutant : « Les plateformes doivent elles aussi redoubler d’efforts pour éliminer proactivement les contenus préjudiciables de leurs plateformes. »

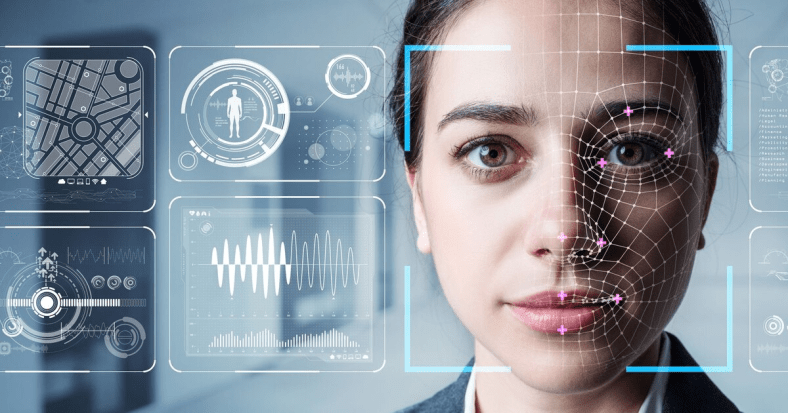

Le témoignage le plus détaillé sur les mécanismes d’application est venu de Susanna Carlos, responsable de la politique musicale chez YouTube. Elle a mis en avant le système Content ID de YouTube, expliquant qu’il aide les titulaires de droits d’auteur en « créant des empreintes numériques pour les œuvres concernées et en analysant la plateforme ». Elle a salué la loi NO FAKES, la qualifiant d’« approche intelligente et réfléchie » et a déclaré : « Nous sommes particulièrement reconnaissants à la présidente Blackburn, au sénateur Coons, à la députée Klobuchar et à tous les auteurs du projet de loi. »

Carlos a confirmé que YouTube développe un nouveau système baptisé « Likeness ID » qui analysera le visage et la voix des utilisateurs et les comparera sur toute la plateforme. Selon elle, ce système « permet aux individus de nous avertir lorsque des copies numériques de leurs contenus sont en ligne » et « est intelligemment repris dans la loi No Fakes Act ». Lors d’un échange avec le sénateur Blackburn, Carlos a reconnu que les plateformes devraient réagir aux avis de retrait « dans les meilleurs délais », mais a refusé de préciser un délai précis.

Le sénateur Chris Coons a demandé à Carlos pourquoi YouTube soutenait le projet de loi. Elle a répondu : « YouTube évolue donc dans un univers tout à fait particulier… Et c’est un domaine dans lequel cette idée de répliques numériques peut causer des dommages concrets. »

Malgré les éloges enthousiastes des participants, la loi NO FAKES pourrait facilement étouffer l’expression légale. Le projet de loi autorise les poursuites judiciaires pour toute « copie numérique non autorisée » et incite fortement les plateformes à privilégier le retrait, sans nécessiter de procédure de contre-avis. Bien que le projet de loi prétende exempter la parodie, la satire et les documentaires, l’Electronic Frontier Foundation a averti que « ces exemptions ont peu de chances de fonctionner dans la réalité ».

En encourageant le retrait rapide et opaque de contenus, à l’instar du système DMCA que le projet de loi cherche à imiter, la loi NO FAKES risque de transformer les plateformes en gardiennes de l’expression légale. Bien que présentée comme étant étroitement adaptée aux images non consensuelles, la loi TAKE IT DOWN contient un langage vague et impose des délais de retrait rapides qui pourraient perturber des discours légitimes.

Alors que Washington continue de présenter l’IA comme une menace exigeant une intervention agressive, les conséquences pour la liberté d’expression deviennent de plus en plus graves. Ce qui relevait autrefois de la modération manuelle et du jugement individuel est désormais confié à des systèmes automatisés soutenus par des lois floues, des pressions politiques et le lobbying des entreprises.

L’élan législatif derrière les lois NO FAKES et TAKE IT DOWN soulève des préoccupations pressantes quant au Premier Amendement. Bien que présentés comme des outils de lutte contre l’usurpation d’identité numérique et les abus liés à l’image, ces projets de loi introduisent des mécanismes étendus qui risquent d’étouffer un large éventail d’expressions protégées, notamment la satire, la parodie, le documentaire et le commentaire politique. Les définitions vagues entourant les « copies numériques non autorisées » créent un effet dissuasif, car les artistes, les journalistes et les utilisateurs ordinaires peuvent s’autocensurer par crainte que leurs contenus ne soient interceptés par des systèmes de retrait rapide.

L’absence d’un processus de contre-avis solide, associée à la menace de lourdes amendes pour les plateformes, encourage la suppression excessive plutôt qu’une modération prudente, faisant de l’expression légale le dommage collatéral d’un excès de pouvoir législatif.

Voir l’article original cliquez ci-dessous :