L’approche plus intelligente et spécifique au site de Cookiecrumbler promet un avenir où le rejet des cookies signifie réellement ce que les utilisateurs pensent.

Brave a annoncé l’open source de Cookiecrumbler, un outil conçu pour la détection automatique « intelligente » des avis de consentement aux cookies sur les sites Web à travers le Web en déployant des LLM open source, a annoncé l’équipe de confidentialité de Brave.

Outre la détection de ces notifications, Cookiecrumbler propose également des correctifs. Les développeurs de l’outil indiquent qu’ils étudient actuellement les moyens d’intégrer Cookiecrumbler au navigateur Brave, mais que cela sera possible après une analyse complète de la confidentialité.

Le fait que l’expérience utilisateur soit « peu conviviale » – c’est-à-dire ennuyeuse – est le moindre des problèmes des fenêtres contextuelles de consentement aux cookies, qui sont censées permettre aux utilisateurs de choisir comment et s’ils sont suivis et profilés.

Mais Brave affirme que les avis eux-mêmes peuvent nuire à la vie privée, citant des recherches indiquant que même lorsqu’un utilisateur choisit de « rejeter tous les cookies », de nombreux systèmes sont censés garantir qu’ils « continuent de suivre les personnes ».

Étant donné que le navigateur Brave, axé sur la confidentialité, bloque par défaut le suivi par des tiers, les fenêtres contextuelles deviennent inutiles. Cependant, la manière dont elles sont bloquées est importante, car certaines implémentations peuvent entraîner la rupture de la fonctionnalité des pages Web, en particulier lorsque le bloqueur utilise des règles génériques.

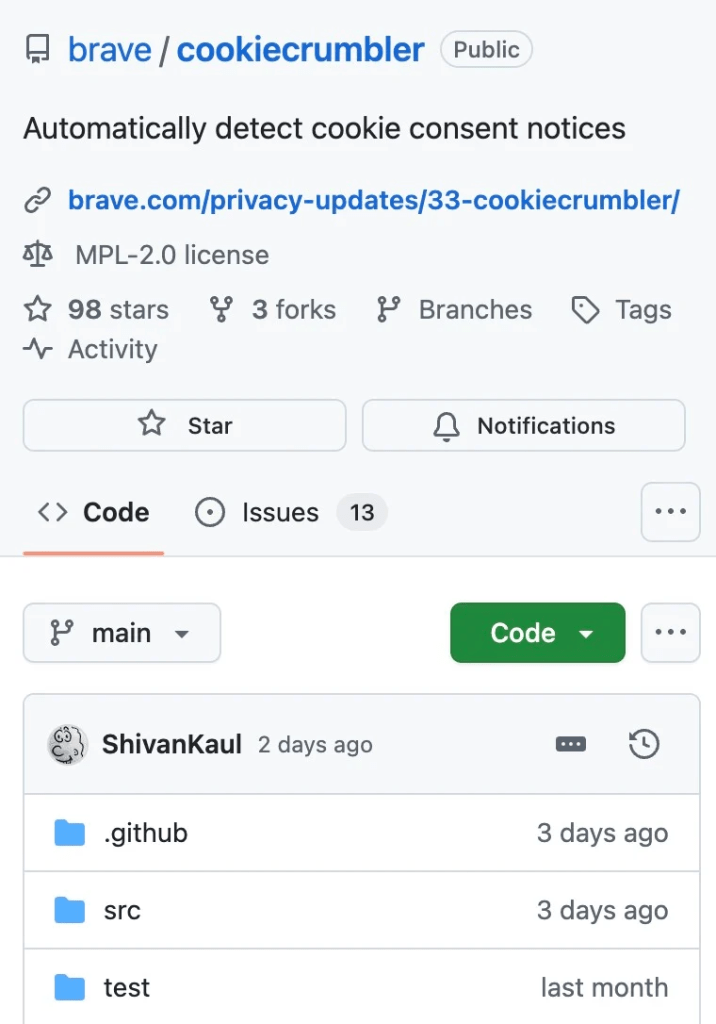

Cookiecrumbler, d’autre part, vise à fournir un blocage spécifique au site sur Internet et dans différents emplacements et langues dans lesquels les avis de consentement aux cookies apparaissent – c’est pourquoi les LLM sont utilisés dans l’automatisation de la détection comme moyen de gérer l’ampleur du travail.

Les créateurs de cet outil affirment également que le faible coût et l’efficacité de cette approche permettent également de recourir à des examinateurs humains, qui recherchent les faux positifs.

Cookiecrumbler détecte les principaux sites Web en utilisant des listes accessibles au public et déploie un script d’exploration pour déterminer s’ils utilisent des avis de consentement aux cookies.

La liste résultante des sites Web qui le font est ensuite publiée dans le nouveau référentiel GitHub de l’outil.

Outre le blocage des trackers, Brave bloque également les notifications par défaut. La différence avec Cookiecrumbler intégré réside dans une automatisation plus efficace, compte tenu de l’ampleur de la tâche, et dans la détection des fenêtres contextuelles de consentement nouvelles ou modifiées.

Les développeurs de Cookiecrumbler affirment que depuis son lancement lors de l’Ad Filtering Dev Summit en 2024, l’outil produit moins de casse et moins de faux positifs tout en élargissant le nombre de langues et la couverture géographique.

Voir l’article original cliquez ci-dessous :