Le tournoi de golf de l’US Open et le nouveau Intuit Dome de la NBA mettent en œuvre une technologie de reconnaissance faciale pour une entrée « sans friction » et une personnalisation des fans, normalisant la surveillance dans les espaces de loisirs publics.

- Les critiques avertissent que la commercialisation de ces systèmes comme des commodités cache des problèmes plus profonds, notamment une diminution de la confidentialité, un manque de consentement éclairé et l’expansion silencieuse de la surveillance biométrique dans la vie quotidienne.

- Les concerts de Taylor Swift et le Madison Square Garden ont utilisé la reconnaissance faciale pour suivre ou bannir des individus à leur insu, soulevant des signaux d’alarme éthiques et juridiques concernant la discrimination, le ciblage et le manque de transparence.

- Les États-Unis ne disposent pas d’une loi fédérale sur les données biométriques. Si certains États, comme l’Illinois et la Californie, disposent de protections, d’autres, comme New York, ont une réglementation incohérente ou limitée, ce qui laisse des lacunes en matière de protection des consommateurs.

- Un article de juin du Barreau de l’État de New York exhorte les législateurs à s’attaquer à ces problèmes, avertissant que le déploiement incontrôlé de la reconnaissance faciale présente de graves risques pour les libertés civiles et la vie privée.

La surveillance biométrique ne se limite plus aux aéroports, aux postes-frontières ou aux zones de haute sécurité. Elle est de plus en plus testée et normalisée sur les fairways, les courts et les halls des stades à travers les États-Unis.

Lors de l’US Open de cette année à Oakmont, en Pennsylvanie, l’Association américaine de golf (USGA) a discrètement étendu l’ utilisation de la reconnaissance faciale pour l’entrée aux événements , en partenariat une fois de plus avec l’entreprise technologique britannique FortressGB et la société d’authentification faciale Wicket. Les spectateurs ont désormais la possibilité d’enregistrer leur visage à l’avance et de franchir les points d’entrée sans présenter de billet physique, pour une expérience fluide.

Cependant, les critiques ont averti que ce cadrage, qui vend la numérisation biométrique comme une simple commodité, masque un changement plus complexe et plus inquiétant : la normalisation de la surveillance faciale dans les espaces publics de loisirs, où les attentes d’anonymat et de confidentialité ont traditionnellement été plus élevées.

Le tournoi de golf n’est pas le seul à adopter cette tendance. De l’autre côté du pays, les Los Angeles Clippers de la National Basketball Association (NBA) s’apprêtent à ouvrir les portes de leur nouveau stade futuriste, l’Intuit Dome, avec une approche plus complète basée sur les données.

Géré par Halo Sports and Entertainment, une société appartenant à Steve Ballmer, ancien PDG de Microsoft et président des Clippers, le stade ne se contente pas de scanner les visages à l’entrée. Il mesure également le niveau sonore à chaque siège pour récompenser les supporters enthousiastes, utilise la reconnaissance faciale pour personnaliser les écrans d’accueil et collecte en continu des données comportementales afin d’améliorer l’expérience des supporters.

Ces deux cas reflètent une tendance croissante dans le sport américain : les stades deviennent des bancs d’essai pour les technologies de surveillance de pointe , sous couvert d’amélioration de la vitesse, de la sécurité et de la personnalisation. Pourtant, à mesure que ces systèmes s’intègrent de plus en plus, leurs conséquences à long terme, notamment en matière de confidentialité des données et de libertés civiles, restent non résolues.

La NYSBA met en garde le public contre le manque de réglementation de la reconnaissance faciale

Un article publié en juin dernier par le barreau de l’État de New York (NYSBA) a mis en garde le public contre l’ utilisation croissante de la technologie de reconnaissance faciale dans les lieux de divertissement .

Cet article, rédigé par Kylie Ruff, diplômée de la promotion 2025 de la faculté de droit de l’Université St. John’s , explore la manière dont les établissements du pays se tournent de plus en plus vers la reconnaissance faciale pour simplifier la sécurité et l’accès. Cependant, il soutient que cela soulève de profondes questions sur la confidentialité, l’équité et l’équilibre entre sécurité et surveillance.

Par exemple, en 2019, l’équipe de sécurité de la pop star Taylor Swift a utilisé des bornes de numérisation faciale dans ses salles de concert pour traquer les harceleurs connus – une mesure qui a déclenché l’alarme lorsqu’il a été révélé que les numérisations avaient été effectuées à l’insu des fans ou sans leur consentement.

Récemment, Madison Square Garden (MSG) Entertainment a essuyé de vives critiques pour avoir utilisé la reconnaissance faciale afin d’exclure des avocats de cabinets engagés dans des litiges contre elle. Une mère s’est vu interdire de voir les Rockettes avec sa fille au seul motif qu’elle travaillait dans un cabinet d’avocats ayant une affaire en cours avec MSG. Aucune de ces exclusions n’était motivée par des antécédents criminels, mais uniquement par des affiliations et des critiques.

Ces pratiques, suggère Ruff, s’approchent dangereusement de l’instrumentalisation des outils de surveillance à des fins de représailles personnelles ou commerciales, sans surveillance ni responsabilité significatives. (Connexe : Un dysfonctionnement de la technologie de reconnaissance faciale peut mettre en danger des personnes innocentes .)

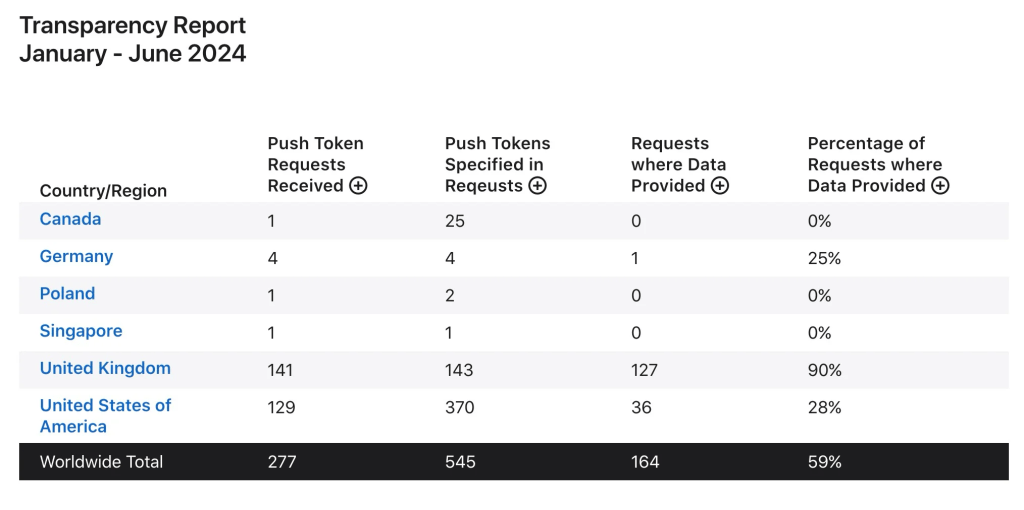

De plus, les États-Unis ne disposent d’aucune réglementation exhaustive régissant la collecte, le stockage et l’utilisation des données biométriques, y compris la reconnaissance faciale. Seuls quelques États, dont l’Illinois et la Californie, ont adopté des lois obligeant les entreprises à obtenir le consentement des utilisateurs ou à proposer des mécanismes de refus. Si la ville de New York impose la divulgation biométrique dans les environnements commerciaux, l’État manque d’une approche uniforme.

Les sources incluent :

Voir l’article original cliquez ci-dessous :